注意到这本书是我在逛西西弗书店的时候。

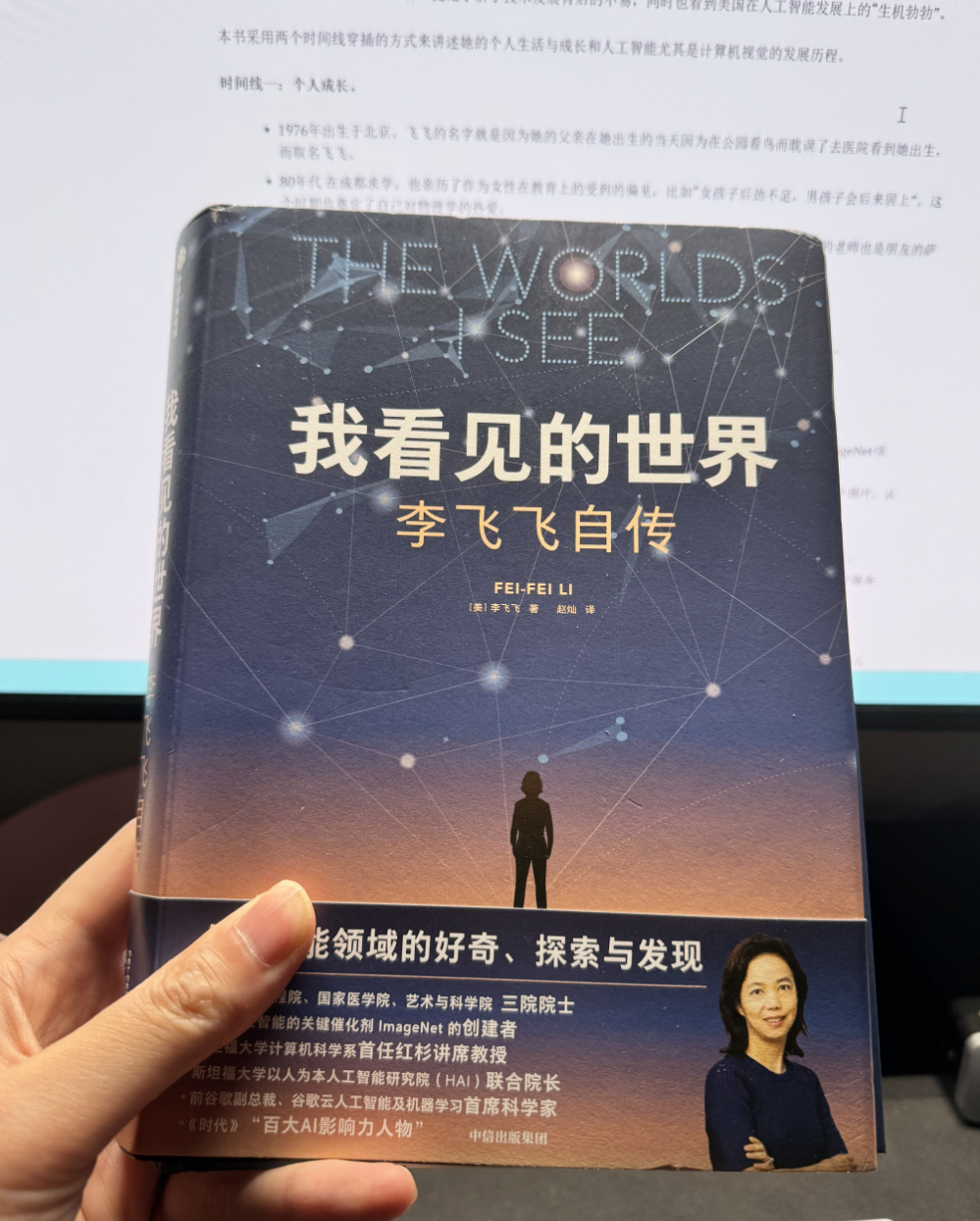

被吸引是因为对李飞飞这个名字如雷贯耳,我在2018年接触深度学习的时候就听说了她的名字以及她背后的ImageNet、ResNet 和她斯坦福的cs213n的课程。

我还在Twitter上问此书值不值得读。后来还是买了一本,今天花了4个小时一口气读完了。

我带着两个角色读完了这本书:一个女儿的父亲,一个人工智能的学习者。

- 我作为一个女儿的父亲(虽然她还很小),我总想知道怎么样的经历、家庭教育造就了一位如此优秀的“女儿”,她能给我什么样的启迪。

- 作为一个人工智能的学习者,我想知道这里面的发展历史、人物关系、技术脉络及大佬们背后的故事。

读完之后我的感受:

- 作为父母,在80年代末冒着巨大的风险移民美国,坚定不移的支持孩子内心的选择,与传统教育多少有点格格不入:学习是为了自己,不是为了名次或者其它。言传身教非常重要。当然,美国藤校也不是随随便便能进去的。

- 作为人工智能的学习者,更是了解了技术发展背后的不易,同时也看到美国在人工智能发展上的“生机勃勃”。

本书采用两个时间线穿插的方式来讲述她的个人生活与成长和人工智能尤其是计算机视觉的发展历程。

时间线一:个人成长。

- 1976年出生于北京。飞飞的名字就是因为她的父亲在她出生的当天因为在公园看鸟而耽误了去医院看到她出生,而取名飞飞。

- 80年代 在成都求学,也亲历了作为女性在教育上的受到的偏见,比如“女孩子后劲不足,男孩子会后来居上”。这个时期也奠定了自己对物理学的热爱。

- 1992 年随家人移民美国。生活拮据,语言不通。这时候在就读的高中遇到了她一生中的重要的老师也是朋友的萨贝拉。

- 1995年 全额奖学金进入普林斯顿大学。母亲病情恶化,接受手术。

- 1997年, 大二,参加加州伯克利大学的项目研究视觉神经元对刺激如何反应,并发表在杂志上。

- 1999年大学毕业,在就业和深造面前,接受母亲的建议:你自己想要的是什么? 而选择读研究生。

- 2000年进入加州大学理工学院读研究生。

- 2002-2004年,开发出单样本学习(one-shot learning)和Caltech 101 数据集。

- 2005 - 2006 博士毕业,开始思考参考WordNet 打造一个ImageNet。

- 2007年,回到普林斯顿大学作为助理教授开启自己的第一个实验室。 和自己的第一个研究生开启ImageNet项目。预期需要19年完成这个项目。

- 2009 年 利用当年亚马逊新出先的众包服务,提前完成了ImageNet的分类与标注,2.2w和分类 1500w个图片。认识了自己的男朋友和未来的丈夫。

- 2010-2011 举办ImageNet 大型识别挑战赛,但是这两年都是支持向量机这样的传统算法,效果一般。

- 2012年,改变历史的一年。AlexNet 横空出世,图片识别准确率提升10个点,达到85%。第一个孩子出生。

- 2013年,从Andrew Ng 手中接任 第七届斯坦福人工智能实验室主任。受其母亲生病的影响,开始研究医疗服务的环境智能。

- 2015 - 2016 AI4ALL 项目。

- 2017- 2018 年, 担任谷歌云人工智能及机器学习首席科学家。

- 2018年6月,在美国国会发表《人工智能-能力越大,责任越大》的演讲,和他一起的还有OpenAI 的联合创始人和CTO Greg Brockman。

- 2020年9月,发表《用环境智能照亮医疗保健的黑暗空间》发表在自然杂志上。

- 2020-2021年,当选美国三院院士。

- 2022年,入选福布斯中国,全球华人精英Top 100。

- 2023年 9月 ,入选《时代》杂志“百大AI影响人物”。

时间线二: 人工智能发展

- 1956 年, “人工智能” 一词诞生。

- 1958年,发明感知机。被认为实在机器认知上的重大进步。

- 20世纪60年代,麻省理工人工智能实验室和斯坦福人工智能实验室已经是世界知名的顶尖实验室。随之机器学习遇冷。

- 20世纪70年代,专家系统诞生。

- 1980年,日本的研究者利用堆叠的多层感知机在字迹识别中取得了突破性进展。

- 1985年, WorldNet 诞生,在NLP领域取得了很大的影响,甚至后面也深深的影响了ImageNet的诞生。

- 1986年,反向传播算法诞生。作者之一是Hilton,他的学生之一Yann LeCun。

- 1992年,Yann Lecun 发明神经网络,应用在手写识别中。

- 90年代,人工智能遇冷。

- 2012年 Hilton的ALexNet 开启深度学习的新革命。

- 2015年 ResNet诞生,错误率4.5% ,已经超过人类。

- 2016年,AlphaGo诞生,DeepMind 研究起来了AGI。

- 2017年,《Attention Is All You Need》发表,继深度神经网络后,Transformer 为深度学习在架构上带来再一次升级。

- 后面,LLM,生成式人工智能蓬勃发展。